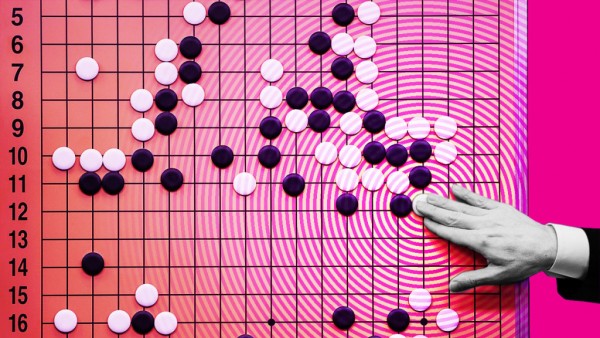

随着Google的人工智能程序AlphaGo以4比1大败南韩围棋棋圣李世石(Lee Sedol),简单的结论是:人工智能(AI)在对抗人类上已达到另一个里程碑,提高了人类的恐惧,担心机器最终可能取代员工,甚至经理人。但是,AlphaGo虽然以令人信服的方式获胜,它已透露,人工智能仍然有一些缺失,特别是在涉及机器的直觉时。

Google在2014年以五亿美元收购了AlphaGo的开发者DeepMind,以扩大其蓬勃发展的人工智能投资组合。AlphaGo的深度学习演算法,借助「走棋网络」( “policy network” )和「估值网络」(“value network”),不仅储存了名人赛过往数百万个棋局,也储存了它和自己对奕的妙招。这两个网络的命名,听起来有管理的意味,而且是以提高效率为目的,不单是为了提升电脑的原始计算能力。「走棋」(”policy’’)有助于缩小最有可能获胜的每一手的广度;而「估值」(“value”)借着评估棋局尚未结束时每个位置的获胜者,从而降低了搜索的深度。在定义良好的棋赛中的规则设定,限制搜索是很有道理的。

但是,在管理者所处的环境下,对竞争规则的管制较少,更重要的是,就利害关系来说,每个结果并不相等。换句话说,在商业上,要紧的不只是你输或赢,也包括输赢多少。在第三局比赛中,这种对人工智能的限制变得很明显,AlphaGo没有增加它的优势,反而下了「悠闲的几手」( “leisurely moves.”)。在围棋方面,每场棋赛都是独立的。AlphaGo只关心赢得那场特定的比赛。不过,在商业上,你成功的重大幅度,可帮助你在后续的比赛中保住你的机会。如果你的竞争对手处于下风,你可能会想让他永远无法翻身。

人们以为AlphaGo拥有的另一个优势,是它的时间管理,其实那是限制。AlphaGo安装了一个特殊的演算法,以便它在下每一手时,所花的时间相同。这个功能的好处是,AlphaGo可避免耗尽比赛规定的时间,而且不会在终局阶段操之过急。这和棋圣李世石形成鲜明的对比,他会在整个比赛的策略性关键时刻,多花几分钟。在AlphaGo唯一尝到败绩的第四局,其致命的一手使用了同样「有效率」的时间。事后来看,更多的分析可能会让AlphaGo走到较安全的位置。在商场上会有这种时候:例行的商业决策可以很快作出,但在公司面临后果影响深远的新状况时,需要花较多时间去思考如何适应及因应。人工智能需要较多时间去发展这个层级的判断。

最后,想一想AlphaGo的自我训练演算法。尽管AlphaGo拥有千年以上的人类下围棋的知识,它的失败归因于一个失误,当下它被打了个措手不及:李世石下了出人意外的一手。更糟的是,AlphaGo的回应不佳,而且直到下了许多手后,才意识到那个失误。内部的学习,无论是在公司或在产业层面上,可能有它的局限性,尤其是在今日的分享经济和聚合经济内。但是,新状况需要新解决方案,那是在古老的策略书上不一定能找到的。经理人经常看着其他地方,例如面临演算法问题的不同产业,希望找到独特的解决方案。此外,即使人类可能比机器容易犯错,我们的优势就在于,有能力承认自己容易犯错并加以改善,正如李世石的做法。等到AlphaGo发现自己的错误而要修正路线时,为时已晚。

人工智能的定义,往往是将人类思想改善到尽善尽美。但正如李世石所言,落败的是他,「不是人类」,定义人类的,可能是我们在不完美中的谦逊和复原力;如果人工智能真的对经理人构成威胁,这些素质仍然有待培养。